شاید برای بسیاری از افراد بخشهای فنی بازاریابی سختترین جنبه آن باشد. به عنوان مثال، وقتی صحبت از سئو تکنیکال میشود، درک نحوه کار فرآیند دشوار است. اما مهم این است که تا آنجا که میتوانیم دانش کسب کنیم تا کارهای خود را به طور موثرتری انجام دهیم.

کراول و یا خزش نیز از حوزههایی است که شاید درک کامل آن برای برخی از افراد دشوار باشد، اما همیشه با کسب اطلاعات و شناخت مسیر یادگیری برای ما سادهتر میشود.

برای درک بالاتر، در ادامه مفهوم خزش و یا Crawl را بررسی کنیم و سه کراولر معروف در دنیای وب را با هم مورد بررسی قرار میدهیم.

خزش یا Crawl چیست؟

خزنده و یا Crawler وب، رباتی است که محتوای موجود در اینترنت را جستجو و ایندکس میکند. اساسا، خزندههای وب وظیفه درک مطالب موجود در یک صفحه وب را دارند تا بتوانند هنگام انجام جستجو آن را بازیابی کنند.

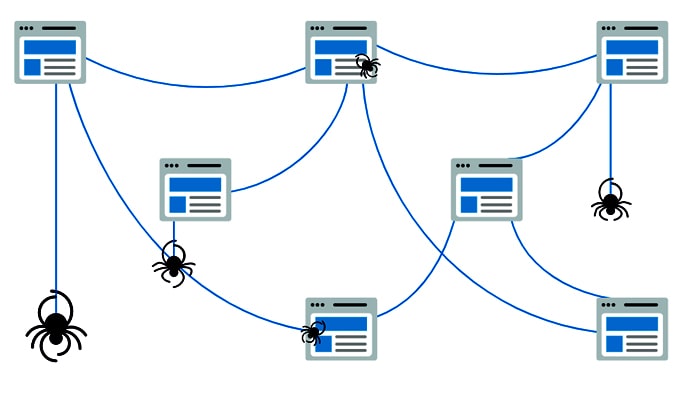

خزیدن فرآیندی است که در آن موتورهای جستجو تیمی از روباتها (معروف به خزنده یا عنکبوت) را برای یافتن محتوای جدید و به روز ارسال میکنند. این محتواها ممکن است نسبت به یکدیگر تفاوتهایی داشته باشند، این محتواها ممکن است یک صفحه وب، تصویر، فیلم، PDF و یا غیره باشند، اما صرف نظر از قالب، محتوا توسط لینکها کشف میشود.

این رباتها با واکشی چند صفحه وب شروع به کار میکند و سپس لینکهای موجود در آن صفحات وب را برای یافتن URL های جدید دنبال میکند. با جست و خیز در این مسیر از لینکها، خزنده قادر است محتوای جدیدی پیدا کند و آن را به فهرست خود به نام کافئین (یک پایگاه داده گسترده از URL های کشف شده) اضافه کند تا بعدا هنگامی که جستجوگر به دنبال یافتن اطلاعات محتوای موجود در آن URL است، به عنوان بهترین مورد تطابقیافته به کاربر ارائه شود.

یک خزنده وب تمام صفحات وب موجود در اینترنت را که خودش میتواند پیدا کند و یا به آن گفته میشود که پیدا کند، فهرست، جستجو و دستهبندی میکند.

این بدان معناست که اگر نمیخواهید یک خزنده وب صفحه وب شما را کراول ویا خزش کند، تا در صفحه نتایج موتورهای جستجو پیدا شود، میتوانید این نکته را به کراولر بگویید.

برای این کار، شما یک فایل robots.txt را بارگذاری میکنید. اساسا، یک فایل robots.txt به موتور جستجو میگوید که چگونه صفحات موجود در سایت شما را خزش (کراول) و ایندکس کند.

خزنده های وب چگونه کار میکنند؟

یک خزنده وب با کشف URL ها، بررسی و دسته بندی صفحات وب و سپس اضافه کردن لینکهای هر صفحه وب به لیست سایتهای خزنده، کار میکند. در عین حال، خزندههای وب هوشمند هستند و اهمیت هر صفحه وب را تعیین میکنند.

این بدان معناست که خزنده وب موتور جستجوگر به احتمال زیاد کل اینترنت را جستجو نخواهد کرد. بلکه، اهمیت هر صفحه وب را بر اساس عواملی از جمله اینکه چند صفحه دیگر به آن صفحه لینک دادهاند، میزان بازدید صفحه و حتی اقتدار نام تجاری، تعیین خواهد کرد.

بنابراین یک خزنده وب تعیین میکند که کدام صفحات را خزش (کرال) کند، به چه ترتیبی آنها را کرال کند و چند وقت یک بار باید برای به روزرسانی این صفحات نیاز است، کرال شوند.

به عنوان مثال، اگر صفحه وب جدیدی دارید یا در صفحه موجود تغییراتی ایجاد شده است، خزنده وب این آپدیت را ثبت کرده و فهرست را به روز میکند.

جالب اینجاست که اگر صفحه وب جدیدی دارید، میتوانید از موتورهای جستجو بخواهید سایت شما را کرال کنند.

وقتی خزنده وب در صفحه شما باشد، به کپی و متا تگها نگاه میکند، این اطلاعات را ذخیره میکند و آنها را فهرست بندی میکند تا برای کلمات کلیدی مرتب شوند.

قبل از اینکه این فرآیند در سایت شما شروع شود، به طور خاص، خزنده وب به فایل robots.txt شما نگاه میکند تا ببیند که باید کدام صفحات را کراول کند، به همین دلیل این موضوع برای سئو فنی بسیار مهم است.

در نهایت، وقتی یک خزنده وب، صفحه شما را کراول میکند، تصمیم میگیرد که آیا صفحه شما نتیجه مناسبی برای نمایش در صفحه نتایج جستجو است و یا خیر. که اگر میخواهید ترافیک ارگانیک خود را افزایش دهید، درک این روند مهم است.

جالب است بدانید که همه خزندههای وب ممکن است رفتار متفاوتی داشته باشند. به عنوان مثال، شاید آنها هنگام تصمیم گیری در مورد مهمترین صفحات وب، از عوامل مختلفی استفاده میکنند.

به زبان ساده، خزندههای وب وظیفه جستجو و ایندکس محتوای آنلاین برای موتورهای جستجو را دارند. آنها با مرتب سازی و فیلتر کردن صفحات وب کار میکنند، بنابراین موتورهای جستجو میفهمند که هر صفحه وب چیست.

معرفی ۳ ربات خزنده معروف در بستر وب

۱- خزنده گوگل

خزنده گوگل با نام گوگل بات و یا ربات گوگل شناخته میشود. گوگل بات نام عمومی دو نوع مختلف از خزنده است:

- خزنده دسکتاپ که کاربر را روی دسکتاپ (Googlebot Desktop) شبیه سازی میکند

- خزنده موبایل که کاربر را در دستگاه تلفن همراه (Googlebot Smartphone) شبیه سازی میکند.

وب سایت شما احتمالاً توسط هر دو نسخه گوگل بات کراول خواهد شد. هر دو نوع خزنده در robots.txt از کد محصول یکسان (رمز عامل کاربر) پیروی میکنند، بنابراین شما نمیتوانید با استفاده از robots.txt به طور انتخابی دسکتاپ و یا گوشی هوشمند را هدف قرار دهید.

گوگل بات صفحات وب را از طریق لینکها کراول میکند. این خزنده مطالب جدید و به روز شده را پیدا میکند، میخواند و آنچه را که باید به فهرست اضافه شود را ایندکس میکند. البته ایندکس، مغز گوگل است. این فضا جایی است که تمام دانش و اطلاعات گوگل در آن قرار گرفته است. گوگل برای یافتن این صفحات و بررسی محتوا، از تعداد زیادی رایانه برای ارسال خزندههای خود به هر گوشه و کنار وب استفاده میکند.

گوگل بات از نقشه سایت (سایت مپ) و پایگاه داده لینکهای کشف شده توسط خزندههای قبلی برای تعیین مکان بعدی استفاده میکند. هر زمان خزنده لینکهای جدیدی را در سایتی پیدا کند، آنها را به لیست صفحاتی که در ادامه بازدید خواهد کرد، اضافه میکند. اگر گوگل بات تغییراتی در لینکها پیدا کند، آن را ثبت میکند تا فهرست به روز شود. این برنامه تعیین می کند که هر چند وقت یکبار صفحات کراول شوند. برای اطمینان از اینکه گوگل بات میتواند سایت شما را به درستی ایندکس کند، باید قابل کراول بودن آن را بررسی کنید. اگر سایت شما در دسترس خزندهها باشد، آنها هر چند وقت یک بار به آن مراجعه میکنند.

برای اینکه بفهمید گوگل بات هر چند وقت یک بار از سایت شما بازدید میکند و چه کاری در آنجا انجام میدهد ، میتوانید پروندههای ورود (log files) را بررسی کنید و یا به قسمت کراول در گوگل سرچ کنسول نگاهی بیاندازید.

شما می توانید با استفاده از robots.txt نحوه بازدید و کراول گوگل از همه و یا بخشی از سایت خودتان را مشخص کنید. مراقب باشید، اگر این کار را به روش اشتباه انجام دهید، ممکن است به صورت کلی از بازدید گوگل بات از سایتتان جلوگیری کنید. با این کار سایت شما از فهرست خارج میشود.

۲- خزنده ahrefs

Ahrefs یک خزنده وب است که پایگاه داده شامل ۱۲ تریلیون لینک دارد که آنها را برای مجموعه ابزار بازاریابی آنلاین Ahrefs تأمین میکند. این خزنده به صورت مداوم وب را کراول میکند تا بانک اطلاعات Ahrefs را لینکها جدید پر کند و همچنین وضعیت لینکهایی را که پیش از این پیدا کرده بود را مورد بررسی قرار میدهد تا اطلاعات جامع و به روز را در اختیار کاربران قرار دهد.

دادههای لینک جمع آوری شده توسط ربات Ahrefs از وب توسط هزاران بازاریاب دیجیتال (دیجیتال مارکتر) در سراسر جهان برای برنامه ریزی، اجرا و نظارت بر بازاریابی آنلاین (آنلاین مارکتینگ) مورد استفاده قرار میگیرد.

این دادهها برای ارائه خدمات سئو ارزش بی نظیری دارد چرا که به متخصصان بازاریابی کمک میکند تا الگوریتمهای گوگل به عتوان بزرگترین موتورهای جستجو در جهان را بهتر درک کنند تا بتوانند وب سایتها را به همین ترتیب بهینه کنند. هر ۲۴ ساعت خزنده Ahrefs از بیش از ۶ میلیارد صفحه وب بازدید میکند و هر ۱۵ تا ۳۰ دقیقه شاخص Ahrefs را به روز میکند.

ربات Ahrefs هنگامی که سایت شما را کراول میکند، لینکهای خروجی را ثبت میکند و آنها را به پایگاه داده اضافه میکند. این ربات همچنین به صورت دورهای وب سایت شما را دوباره بررسی میکند تا وضعیت فعلی لینکهایی که قبلا ثبت کرده را بررسی کند.

این خزنده اطلاعات دیگری درباره وب سایت شما جمع آوری یا ذخیره نمیکند. این خزنده در وب سایت شما تبلیغات ایجاد نمیکند و به ترافیک ثبت شده در گوگل آنالیتیکز اعدادی اضافه نمیکند.

خزنده Ahrefs بخشی جدایی ناپذیر از Ahrefs Suite است، و میان افرادی که با سئو سر و کار دارند ابزاری محبوب است. اگر اشتراک Ahrefs دارید (برای استفاده از ابزارهایی مانند کاوشگر سایت، کاوشگر محتوا، کاوشگر کلمات کلیدی ، ردیاب رتبه و غیره)، میتوانید از خزنده Ahrefs به صورت رایگان استفاده کنید.

Ahrefs به شما امکان می دهد به راحتی ایشوها ((issues را از نظر اهمیت فیلتر کنید (خطاها، هشدارها، اعلانها).

برای هر ایشو، میتوانید ببینید که نتایج کاملا جدید هستند و یا در کراول قبلی پیدا شده بودند.

مزیت Ahrefs نسبت به سایر خزندهها این است که میتوانید ستونهای اضافی را به گزارش موجود اضافه کنید. همچنین میتوانید ببینید که کدام URL ها در نقشه سایت موجود هستند و کدام یک نیستند. هر چند این ابزار محدودیتهایی نیز دارند. شما نمیتوانید نتایج کراول را با همکاران خود به اشتراک بگذارید، بنابراین فقط یک نفر میتواند همزمان با کراول کار کند.

۳- خزنده SEMrush

ربات SEMrush یک نرم افزار ربات جستجو است که SEMrush برای کشف و جمع آوری دادههای وب جدید و به روز از آن استفاده میکند.

دادههای جمع آوری شده توسط ربات SEMrush برای موارد زیر استفاده میشود:

· فهرست موتور جستجوی بک لینک عمومی به عنوان ابزاری اختصاصی به نام Backlink Analytics (وب گراف لینکها) نگهداری میشود

· ابزار سایت رسیدگی (Site Audit tool)، که به تحلیل سئو در صفحه، مسائل فنی و کاربردی میپردازد

· ابزار Backlink Audit، که به شما کمک میکند لینکهایی که به صورت بالقوه خطرناک هستند را در پروفایل خود کشف و سپس پاک کنید

· ابزار Link Building ، که به شما در یافتن چشم اندازها کمک میکند، به آنها دست پیدا کنید و بک لینکهایی که تازه به دست آوردهاید، را کنترل کنید

· ابزار SEO Writing Assistant برای بررسی در دسترس بودن URL

· ابزار نظارت بر برند برای فهرستبندی و جستجوی مقالات

· گزارشات تجزیه و تحلیل محتوا و پیگیری پست

· گزارشهای On Page SEO Checker و SEO Content Tools (بررسی سئو بر صفحه و ابزارهای سئو محتوایی)

· ابزار گزارشات تحقیق بر موضوع

· ابزار A / B تست برای سئو برای ایجاد تستهای A / B در وب سایت

روند کرال ربات SEMrush با لیستی از URL های صفحات وب شروع میشود. وقتی ربات SEMrush از این URL ها بازدید میکند، لینکها را برای کراول بیشتر از صفحه ذخیره میکند. این لیست که با نام «مرز کراول»، (crawl frontier) نیز شناخته میشود ، بارها و بارها با توجه به مجموعهای از سیاستهای SEMrush مورد بازدید قرار میگیرد تا به طور موثر یک سایت را برای به روزرسانی نقشه برداری کند، تغییرات محتوایی، صفحات جدید و لینکهای مرده از جمله مواردی هستند که مورد بررسی قرار می گیرند.

SEMrush ابزاری شناخته شده برای تحقیقات درباره رقبا است. اما همچنین به شما این امکان را میدهد وب سایت خود را کراول کنید.

SEMRush برای تشخیص موضوعات اساسی سئو کاملا مناسب است. هنگامی که به تب موضوع (Issues ) میروید ، تمام مشکلات شناسایی شده سئو را در یک داشبورد مشاهده میکنید. SEMRush مسائل را بر اساس اهمیت تقسیم میکند (خطاها / هشدارها / اعلانها) و برای هر موضوع می توانید روند را مشاهده کنید تا بلافاصله در صورت جدید بودن موضوع متوجه شوید. اشکال اصلی SEMrush فیلترهای نامناسب است. این حوزهای است که SEMRush باید به آن رسیدگی کند.

فرض کنید شما میخواهید صفحات ایندکس نشده را ببینید. باید این مسیر را دنبال کنید.

Site audit -> Issues -> blocked from crawling

متاسفانه، این گزارش تنها صفحات ایندکس نشده را نشان میدهد، بلکه صفحاتی را که توسط robots.txt اعلام کردید که مجاز نیستند را نیز نمایش میدهد و نمیتوانید نتایج را فیلتر کنید.

اگر شما نیاز برای رسیدگی اولیه مربوط به سئو برای یک وب سایت کوچک دارید، SEMrush برای شما مناسب است، اما نمیتوانید از این ابزار برای وب سایتهای بزرگ استفاده کنید. خزنده SEMrush فقط امکان کراول تا بیست هزار URL در هر کراول را فراهم میکند.