تنظیم درست فایل Robots که در زبان فارسی روبوت خوانده میشود؛ یکی از تنظیمات مهم و حیاتی در بخش سئوی داخلی سایت است. بسیاری از سئو کاران کمتجربه و صاحبان سایتها، به این موضوع اهمیت نمیدهند؛ چراکه کمتر پیش میآید سایتی از نداشتن فایل Robots در همان مراحل اولیه آسیب ببیند. اما با رشد سایت و افزایش تعداد صفحات سایت، اهمیت داشتن فایل Robots با تنظیمات درست بیشتر میشود.

در این مقاله وبسایت نوین مارکتینگ میخواهم به زبان ساده شما را با کاربرد، ساخت و تنظیمات فایل Robots.txt آشنا کنم. فراموش نکنید که یک سایت بدون فایل Robots شرایط بهتری از یک سایت دارای فایل Robots با تنظیمات اشتباه خواهد داشت. پس از مطالعه این مقاله به خوبی درک خواهید کرد که تنظیمات اشتباه در این فایل چه بلایی بر سر سئوی سایت خواهد آورد.

برای دریافت مشاوره سئو با تیم نوین مارکتینگ در تماس باشید

از اینجا بخوانید : فرصت های از دست رفته برای ایجاد لینک: بازیابی لینک های معیوب

آشنایی با کاربرد فایل Robots

فایل Robots همانطور که از نامش پیداست؛ فایلی برای ارائه دستورات گوناگون به رباتهای کراولر موتورهای جستجو است. در واقع با کمک این فایل شما میتوانید به کراولرها دستور دهید به چه صفحاتی از سایت دسترسی داشته باشند؛ و از جستجو در چه صفحاتی اجتناب کنند.

وقتی کراولر یک موتور جستجو وارد صفحهای از سایت شما می شود؛ در اولین قدم به بررسی این فایل میپردازد. این کار کمک میکند تا دقیقا متوجه شود چه بخشهایی از سایت را باید جستجو کرده و ایندکس کند؛ و به چه بخش هایی از سایت کاری نداشته باشد.

توجه کنید که هر سایتی با توجه به رتبه و اعتبار خود نزد موتور جستجو، شاخصی به نام Crawl Budget دارد. مفهوم این شاخص میزان منابع و زمانی است که موتور جستجو برای کراول کردن روزانه سایت شما در نظر گرفته است. در نتیجه اگر شما نتوانید با دستورات درست در فایل Robots این بودجه را به بهترین وجه و روی صفحات مهم هزینه کنید؛ شانس خود را برای ایندکس سریعتر صفحات و رفرش تغییرات در گوگل از دست خواهید داد.

به عنوان یک مثال ساده در نظر بگیرید که این روزها اکثر سایتها به دلایل مختلف (مثل پارامترهای صفحات) دارای صفحات بدون کاربرد و مشابه زیادی هستند؛ که ایندکس شدن آنها نه تنها Crawl Budget شما را مصرف میکند؛ بلکه موجب ایندکس صفحات مشکلدار و مشابه با صفحات اصلی میشود. در نتیجه به همین راحتی ممکن است مورد خشم گوگل واقع شده و حتی تا مرز پنالتی شدن سایت در گوگل نیز پیش بروید!

در عمل شما با تنظیمات فایل Robots اثر زیادی بر چگونگی ایندکس صفحات سایت خود در موتورهای جستجو خواهید داشت. در چنین شرایطی قابل حدس است که وجود حتی یک تنظیم غلط چگونه میتواند به وضعیت سئو و رتبه صفحات سایت شما در نتایج جستجو آسیب بزند.

البته نگران نباشید. ساخت و تنظیم این فایل آنقدرها هم که تصور میشود پیچیده نیست؛ و با خواندن این مقاله به راحتی میتوانید این فایل را برای سایت خود ساخته و تنظیم کنید.

فقط باز هم تاکید میکنم نبودن یک تنظیم درست در فایل Robots بسیار بهتر از وجود یک تنظیم غلط در آن است.

آموزش ساخت فایل Robots

در اولین قدم سایت شما باید این فایل را داشته باشد؛ تا بتوان تنظیمات مورد نظر را در آن درج کرد. البته بسیاری از سایتها به دلیل استفاده از سیستمهای مدیریت محتوا (CMS) از جمله وردپرس (WordPress) به طور پیشفرض دارای این فایل با تنظیمات اولیه هستند.

فایل robots.txt یک فایل متنی است که به راحتی با نرم افزار Notepad ویندوز میتوانید آن را بسازید. فقط کافی است یک فایل جدید با نام robots و پسود txt ایجاد کرده و آن را ذخیره کنید. به همین سادگی فایل Robots شما آماده است؛ و میتوانید تنظیمات مختلف را در آن درج کنید.

برای خوانده شدن فایل Robots توسط رباتهای موتورهای جستجو، باید آن را در پوشه اصلی (Root) سایت قرار دهید. دقت کنید که نام این فایل دقیقا باید robots و پسوند آن txt باشد.

آشنایی با دستورات قابل تنظیم در فایل Robots

این بخش مهمترین بخش مقاله است؛ و در آن با روش تنظیم فایل Robots آشنا میشوید. این فایل ساختاری مشخص و چندین دستور مختلف دارد؛ که در ادامه مقاله با آنها آشنا میشوید.

دستور User-agent

این فرمان به طور دقیق مشخص میکند که دستورهای بعدی آن، برای چه رباتی از چه موتور جستجویی نوشته شده است. در واقع با این دستور شما رباتی را که میخواهید به آن دستوراتی را بدهید، صدا میکنید. توضیح این نکته ضروری است که موتورهای جستجوی مختلف مثل گوگل، بینگ، یاهو و… هر کدام چندین ربات جستجوگر دارند. به عنوان مثال موتور جستجوی گوگل دارای رباتی برای جستجوی تصاویر، ربات ویدئو، ربات اخبار، ربات موبایل، ربات ادسنس و… است.

برای استفاده از این دستور کافی است به روش زیر عمل کنید:

User-agent: * این دستور برای صدا زدن همه رباتها از همه موتورهای جستجو است.

User-agent: Googlebot این دستور برای صدا زدن ربات اصلی موتور جستجوی گوگل است.

User-agent: Googlebot-Image این دستور برای صدا زدن ربات تصویر گوگل است.

User-agent: Googlebot-News این دستور برای صدا زدن ربات بخش اخبار گوگل است.

User-agent: Googlebot-Mobile این دستور برای صدا زدن ربات موبایل گوگل است.

User-agent: Mediapartners-Google این دستور برای صدا زدن ربات موتورهای جستجوی همکار گوگل است.

User-agent: Adsbot-Google این دستور برای صدا زدن ربات تبلیغات در گوگل است.

در این زمینه موتورهای جستجوی دیگر نیز دستورات مشابهی دارند؛ اما در بیش از ۹۰ درصد از سایتها، بخصوص در سایتهای فارسی، تنها استفاده از دستور اول و شاید دستور دوم، شما را به آنچه لازم دارید میرساند.

پس فعلا در ابتدای فایل Robots خود بنویسید User-agent: * تا مخاطب دستورات که در ادامه میآید، همه رباتهای همه موتورهای جستجو باشد.

دستور Disallow

این دستور به ربات مورد نظر میگوید که از کراول کردن فایل، فولدر یا نوع خاصی از URL در سایت شما اجتناب کند. نکته حساس در زمینه استفاده از دستور Disallow در فایل Robots این است که این دستور راه حل کاملی برای جلوگیری از ایندکس شدن یک صفحه خاص در موتور جستجو نیست. در واقع دستور Disallow از ایندکس نشدن یک صفحه از سایت جلوگیری نمی کند؛ و اگر لینک صفحه Disallow شده در جایی از وب باشد؛ ممکن است گوگل آن را ایندکس کند.

پس برای جلوگیری از ایندکس شدن یک صفحه از سایت در نتایج جستجو، باید از تگ noindex در بخش Head همان صفحه استفاده کنید.

برای استفاده از دستور Disallow کافی است به روش زیر عمل کنید:

Disallow: / این دستور میگوید ربات مد نظر نباید هیچ صفحهای از سایت را کراول کند.

Disallow: /admin این دستور میگوید ربات مدنظر نباید فولدر admin سایت را کراول کند.

Disallow: /*.asp این دستور میگوید ربات مدنظر نباید فایلهای با پسوند asp را کراول کند.

Disallow: /downloads/*.pdf این دستور میگوید ربات مدنظر نباید فایل های PDF موجود در پوشه downloads را کراول کند.

Disallow: /*?tierand این دستور میگوید ربات مدنظر نباید صفحاتی که در URL خود دارای پارامتر tierand را کراول کند.

Disallow: /*? این دستور میگوید ربات مدنظر نباید صفحات دارای پارمتر را ایندکس کند.

Disallow: */member/ این دستور میگوید ربات مدنظر نباید فولدر member را در هر فولدری از سایت کراول کند.

دستور Allow

دستور Allow دقیقا برعکس دستور Disallow است. یعنی به ربات مدنظر اجازه میدهد که بخشی از سایت را کراول کند. البته توجه کنید که دستور Allow تنها برای تکمیل دستور Disallow استفاده میشود. چراکه موتورهای جستجوی به صورت پیشفرض هر بخشی از سایت را که دستور disallow نداشته باشد، مجاز در نظر میگیرند.

برای درک بهتر مسئله به مثال زیر توجه کنید:

شما با دستور زیر فولدر بخش مدیریت یک سایت وردپرسی را Disallow کردهاید:

Disallow: /wp-admin

اما میخواهید رباتها به صورت استثنا، به فایل admin-ajax.php که در این فولدر قرار دارد، دسترسی داشته باشند. برای این کار دستور زیر را به فایل Robots خود اضافه میکنید:

Allow: /wp-admin/admin-ajax.php

یکی از کاربردهای این دستور حل مشکل Blocked Resources است. یعنی به کمک این دستور میتوانید دسترسی ربات به فایل های CSS و JS که مستقیما در صفحات سایت به کار رفتهاند را مجاز کنید؛ بدون آنکه دسترسی ربات به سایر بخشهای فولدر مدنظر مجاز شود.

دستور Noindex

این دستور در موارد کمی به کار میرود؛ و موتورهای جستجو نیز کمتر از آن پیروی میکنند. به همین دلیل در کمتر مقاله مرتبطی نشانی از آن خواهید یافت. اما تحقیقات سایت Stone Temple نشان میدهد که این دستور میتواند هنوز هم کاربرد داشته باشد.

دستور Noindex دقیقا مانند دستور Disallow به کار میرود؛ با این تفاوت که هدف آن ارسال این پیام به ربات موتور جستجو است که بخش یا صفحه مدنظر را به طور کلی ایندکس نکند.

بسیاری از متخصصان بهینه سازی سایت اعتقاد دارند که این دستور کارایی ندارد و رباتها آن را در نظر نمیگیرند؛ اما تحقیقات اشاره شده ثابت کرده است که دستکم رباتهای کراولر گوگل، در بیش از ۸۰ درصد موارد به آن عمل میکنند.

در این زمینه توجه به این نکته بسیار مهم است که پیشنهاد گوگل استفاده از تگ Noindex در بخش head صفحات مدنظر است؛ اما در شرایط استثنایی که این کار غیر ممکن به نظر میرسد؛ این دستور میتواند به کمک شما بیاید.

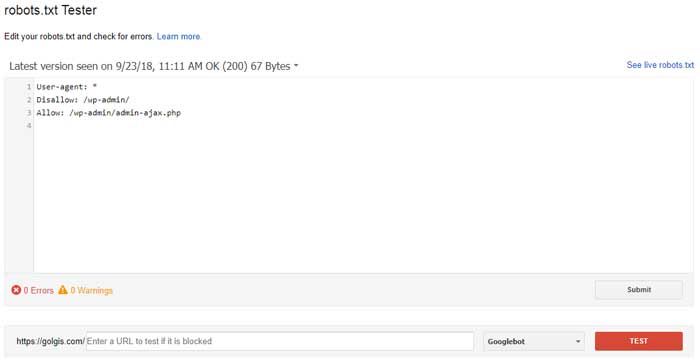

سنجش درستی تنظیمات فایل Robots

در نهایت فایل Robots شما باید دارای متنی شبیه به مثال زیر باشد:

User-agent: *

Disallow: /wp-

Disallow: /*?

Allow: /wp-content

اما از کجا متوجه شویم که فایل robots به درستی کار میکند؟ بهترین روش برای تست این فایل استفاده از ابزارrobots.txt Tester در گوگل سرچ کنسول است.

به کمک این ابزار میتوانید صفحات مختلف سایت خود را از نظر دسترسی رباتها به آن بررسی کنید. همچنین این ابزار خطاها و هشدارهای احتمالی درباره وجود اشتباه در متن فایل Robots را به شما گوشزد میکند.

نقشه سایت در فایل Robots

این کار الزامی نیست؛ اما بسیاری از متخصصان سئو معتقد هستند که قرار دادن آدرس نقشه سایت در انتهای فایل robots به رباتهای موتور جستجو کمک میکند سریعتر به نقشه سایت دسترسی داشته و صفحات سایت را منظمتر و بهتر ایندکس کنند.

برای انجام این کار کافی است در انتهای فایل Robots دستور زیر را وارد کنید:

Sitemap: https://your-domain.com/sitemap.xml

نگاهی به فایل Robots چند سایت مطرح

فایل robots همه سایتها در دسترس شما قرار دارد و تنها با قرار دادن متن robot.txt در انتهای آدرس هر سایت به آن دسترسی پیدا خواهید کرد.

بررسی فایل Robots سایتهای مطرح و موفق علاوه بر اینکه میتواند نمونهای خوب از روش تنظیم این فایل باشد (اگرچه شرایط هر سایت با سایت دیگر متفاوت است.)؛ جذابیتهای خاصی نیز دارد. چراکه این فایل گاهی محل شیطنت و سرگرمی صاحبان سایت هم میشود.

برای نمونه فایل روبوت سایتهای زیر را بررسی کنید:

- نایکی

- Seer Interactive

- یوتیوب

- لست اف.ام

- ردیت

- یلپ

در آخر پیشنهاد میکنم برای داشتن سایتی منظمتر و بهتر از نظر گوگل، علاوه بر اینکه این فایل را به درستی تنظیم میکنید؛ به تنظیمات داخلی و تگهای head صفحات خود نیز توجه کنید. در این زمینه بخصوص به جلوگیری از ایجاد تضادها دقت نمایید.

به عنوان مثال وقتی در head صفحهای از تگ Noindex استفاده کردهاید؛ نباید در فایل Robots از دستور Disallow استفاده کنید؛ یا آن صفحه را ریدایرکت کنید. این کار باعث میشود ربات مدنظر اصلا صفحه را نخواند و در نتیجه اصلا تگ noindex را نبیند! در این زمینه بهتر است در ابتدا از روش کدنویسی و تنظیمات سایت مشکل را برطرف کنید. و تنها مواردی که از این طریق قابل انجام نیستند را از طریق فایل Robots تنظیم نمایید.

در نهایت امیدوارم این مقاله برای شما مفید واقع شده باشد. توجه کنید که فایل Robots تنها یک راهنما برای موتورهای جستجو است؛ و الزامی برای رعایت دستورات آن از طرف موتورهای جستجو وجود ندارد. البته در این خصوص موتور جستجوی گوگل که اصلیترین و حتی تنها هدف سئوی بسیاری از سایتها است؛ تا حدود زیادی به دستورات این فایل احترام میگذارد.